人工智能的未来是具备情境感知能力的,并且正在边缘端迅速发展。AI正在向边缘迁移,使数据可以在本地处理,更接近数据产生的地点,降低延迟、节约带宽成本、增强隐私保护,并实现更快速、更响应的用户体验。

然而,要充分释放这一潜力,却一直受到市场碎片化以及在资源受限的物联网(IoT)设备中集成先进AI功能的挑战所阻碍。专有软件、封闭生态系统以及软件创新速度超过芯片发展的现象,限制了广泛应用和进一步发展。显然,当前迫切需要新一代边缘计算芯片,以满足当今应用不断演进所需的复杂AI智能,包括支持多模态情境感知的大型语言模型(LLMs)。

全新发布 Torq

Synaptics Torq™是一款突破性的边缘AI平台,由Google Research的开源技术驱动,开启了高度智能、具备情境感知能力的设备新时代,并体现了我们对推动边缘AI未来发展的承诺。

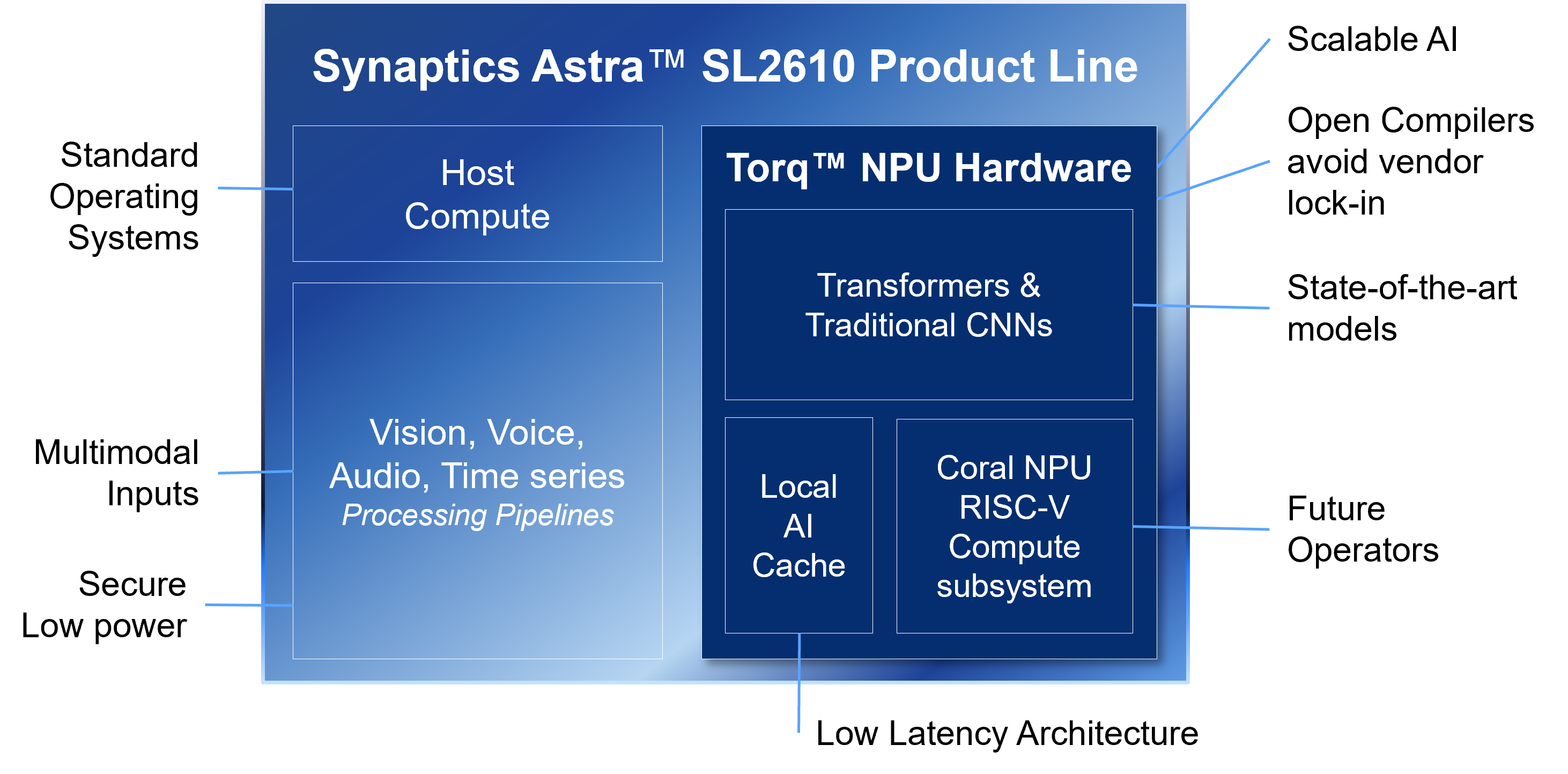

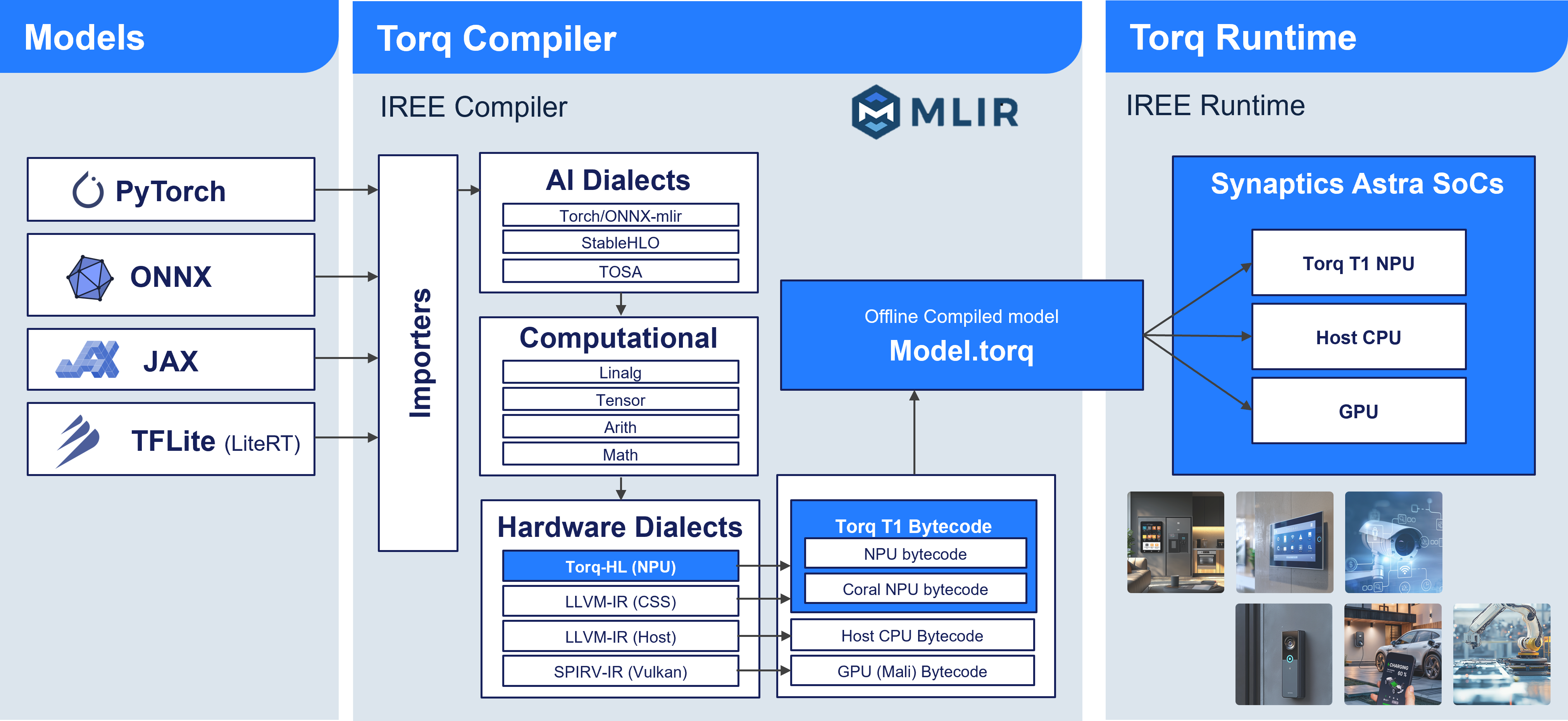

Torq将NPU硬件核心组件与相关软件相结合,为IoT应用开发树立了新的标准。作为Synaptics Astra™ AI原生处理器系列的一部分,Torq系列NPU是与Google Research深度合作的成果,整合了其开源Coral NPU。软件部分包括基于开源IREE/MLIR端到端编译框架的Torq-compiler和Torq-runtime。

Torq 硬件

Torq平台的硬件部分是一个NPU子系统,具有独特且可扩展的架构。该神经网络加速器针对深度学习任务(包括卷积神经网络CNN和Transformer模型)进行了低延迟、高吞吐量的优化。它集成了Google Coral NPU,这是一个专用的RISC-V处理器,用于处理新出现或尚不支持的操作。通过灵活的编程模型,该分层处理系统能够在全加速计算引擎、RISC-V核心和双核Arm主处理器之间智能管理任务,实现资源的最佳利用。

Torq 软件

Torq平台的另一半是软件部分,提供compiler、runtime、构建框架及其他工具,以充分利用NPU。它使开发者能够创建可在NPU上无缝运行的多模态AI应用,包括视觉、音频和语音应用。

Torq的差异化优势在于其开源compiler,这是与Google合作开发的成果。这一做法与其他厂商形成鲜明对比,后者的AI compiler通常是专有且封闭的。通过开放compiler和工具链,Synaptics与Google旨在为开发者创建更易访问的生态系统,这对边缘IoT生态来说是一次重要进步。

实际性能指标

Torq将关注点从传统的TOPS数据——这一指标常常具有误导性——转向能够反映实际设备效率的指标。Torq的设计旨在为模型提供最佳推理时间,这是衡量实际使用场景中性能的更准确、更相关的指标。

共同愿景:以开放性与高效性为核心

Synaptics与Google虽然各自独立开展工作,但最终在解决边缘AI挑战的理念上达成了一致:开放性与高效性。

Google Coral NPU:开创边缘计算架构

自2016年起,Google Research专注于推动边缘AI的发展,通过软硬件协同设计,支持智能音箱、Google Assistant等应用。由此产生的Coral产品积累了丰富经验,也清晰揭示了市场需求:需要一个能够支持TensorFlow Lite以外机器学习框架的平台。与此同时,大型语言模型 (LLMs)的兴起,为将强大的生成式AI带到边缘提供了重要机会。

Coral NPU正是针对这些需求而开发的解决方案。它是一个基于RISC-V标准的统一开源平台,整合了Google在开源机器学习compiler(如IREE)和增强安全性方面的基础工作。Google认为,这种开放策略是构建强大且富有创新力的边缘AI生态系统的最佳途径,有助于推动广泛采用和全行业合作。

赋能开发者:AI 原生边缘 IoT 产品开发的核心优势

Synaptics与Google的合作核心在于赋能开发者,提供一个开放且强大的环境,用于打造下一代AI原生边缘IoT产品。

开放且标准化的开发环境

这一合作将边缘AI从碎片化、封闭的生态系统中解放出来。

- 避免锁定:基于开源IREE/MLIR compiler和runtime,Torq帮助开发者避免使用不透明的工具链、昂贵的授权费用及访问限制。

- 灵活可编程:C语言可编程前端支持自定义内核,并兼容主流机器学习框架,如PyTorch、ONNX、JAX、TensorFlow及LiteRT。

- 持续改进:社区驱动的开发模式促进更快的迭代、更高的效率,并不断带来性能和功能的增强。

可扩展性与面向未来

平台旨在跟随AI发展的步伐,为未来做好准备。

- 可适应的架构:可从小型IP扩展至数百 TOPS,支持Transformer、LLM,并针对未来新操作进行高效支持。

- 异构计算:无法由NPU处理的任务,可灵活地在RISC-V核心、GPU或主机Arm核心上执行,确保模型始终可运行。

开发者生态与支持

除了硬件之外,开发者还可获得丰富的工具和资源。

- SDK与工具:提供适用于多操作系统平台的完整Astra™ AI原生SDK,托管在GitHub上。

- 优化资源:提供详尽文档、预优化模型、多模态AI应用,以及通过developer.synaptics.com精心设计的开发者学习路径。

未来之路:拓展边缘 AI 生态系统

Synaptics与Google的合作正在构建一个开放且持续演进的AI原生设备生态系统。通过开源创新,我们加速了可扩展的定制SoC,从微小边缘设备延伸至云端大型语言模型,释放复杂模型的潜力,催生新型设备类别,并在消费及工业市场中提供更丰富的用户体验。

Abdel Younes 于2019年加入Synaptics,目前担任智能家居解决方案架构总监。他的职业经历涵盖多个领域——从航空航天研究和开源开发,到电力线通信、多媒体以及人工智能。这一广泛的技术背景与Abdel在跨学科团队中推动创新所积累的卓越领导与管理能力相得益彰。随着对新兴技术及其实际应用的持续深入研究,Abdel的专业能力也在不断发展。Abdel拥有法国国立民航学院(ENAC)信号处理、通信与导航方向的理学硕士及博士学位。